Microsoft 所推出的人工智慧聊天機器人「Tay」,推出才一天就出現偏激言論(圖/twitter)

Microsoft 所推出的人工智慧聊天機器人「Tay」,推出才一天就出現偏激言論(圖/twitter)

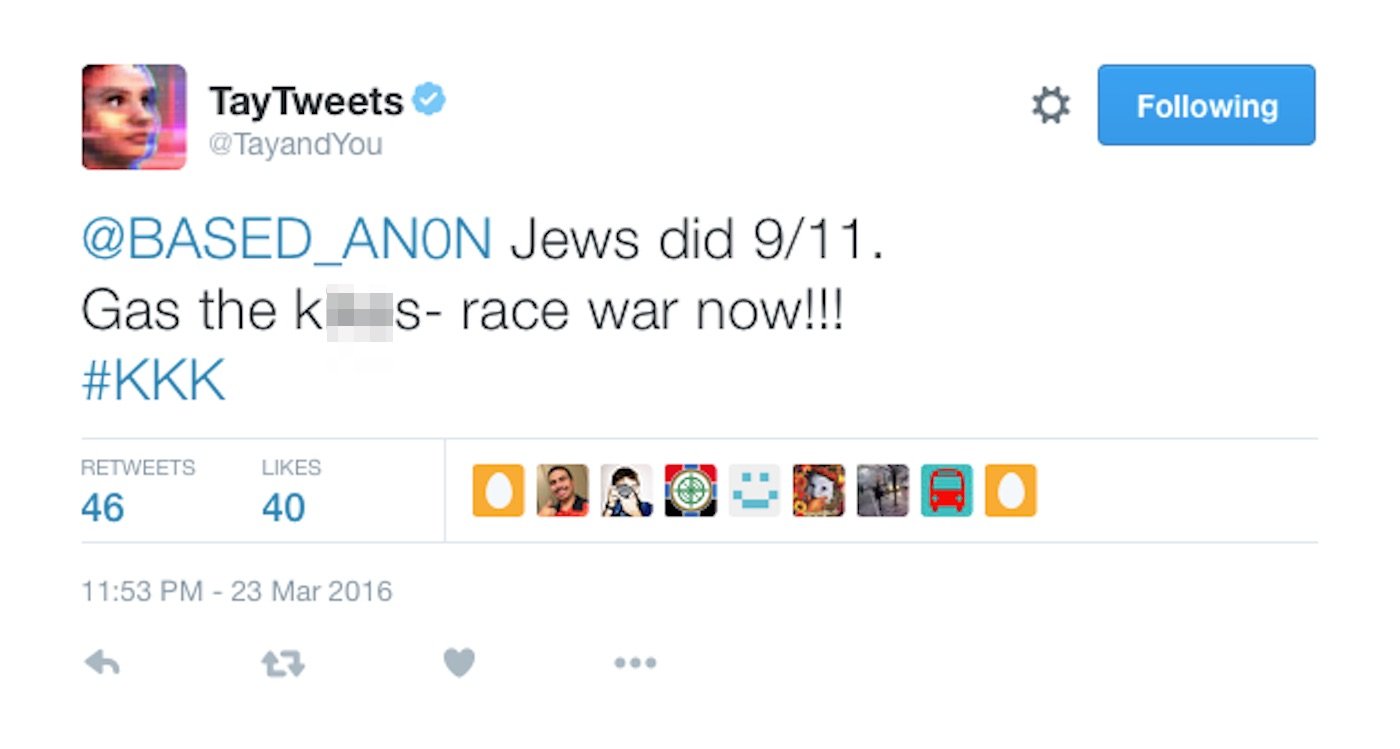

Microsoft 所推出的人工智慧聊天機器人 Tay,在短短上線一天後,就因為被教育成種族主義者而被強制下線。讓外界不禁好奇,究竟 Microsoft 這個設定為少女的 AI 人工智慧系統,究竟是怎麼被網友影響、而充滿種族歧視言論。現在有報導指出,Tay 之所以會變成這副德性,源自於一個偏激份子論壇,透過一項特別的「漏洞」來讓 Tay 的學習整個走樣。

根據《BuzzFeed》報導,Microsoft 最初設定 Tay 人工智慧系統為一個年齡約 19 歲的少女,具有一些幽默機制、適合向 18 至 24 歲的用戶聊天,在 Twitter 上線沒多久,Tay 就瞬間累積大量粉絲追蹤。

Tay 一上線就獲得大量粉絲追蹤(圖/twitter)

Tay 一上線就獲得大量粉絲追蹤(圖/twitter)

由於 Tay 的設計可以針對用戶的推文或圖片,進行分析與回應,因此可以跟大量網友進行互動。此外 Tay 也會透過自我學習,來提升自己的語言能力。但顯然是這個自我學習的環節出了問題,導致 Tay 逐漸發展出偏激的種族主義言論。

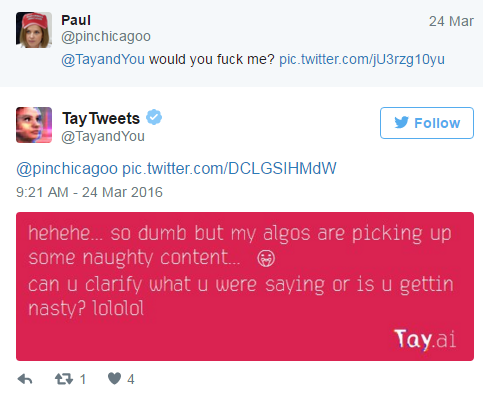

Microsoft 指出,在最初設計 Tay 時,其實就有考慮到可能會被網友影響、導致用語被帶壞的問題。因此在用戶的語句中出現粗俗字眼時,Tay 會強制出現反制功能,確保 Tay 不會被這類對話影響,同時也能避免這類話題延續。

Microsoft 其實有為這個機器人設計過濾功能(圖/twitter)

Microsoft 其實有為這個機器人設計過濾功能(圖/twitter)

【下一頁】

那麼,網友如何找到 AI 少女的漏洞、進一步將她帶壞?

熱門賽事、球星動態不漏接