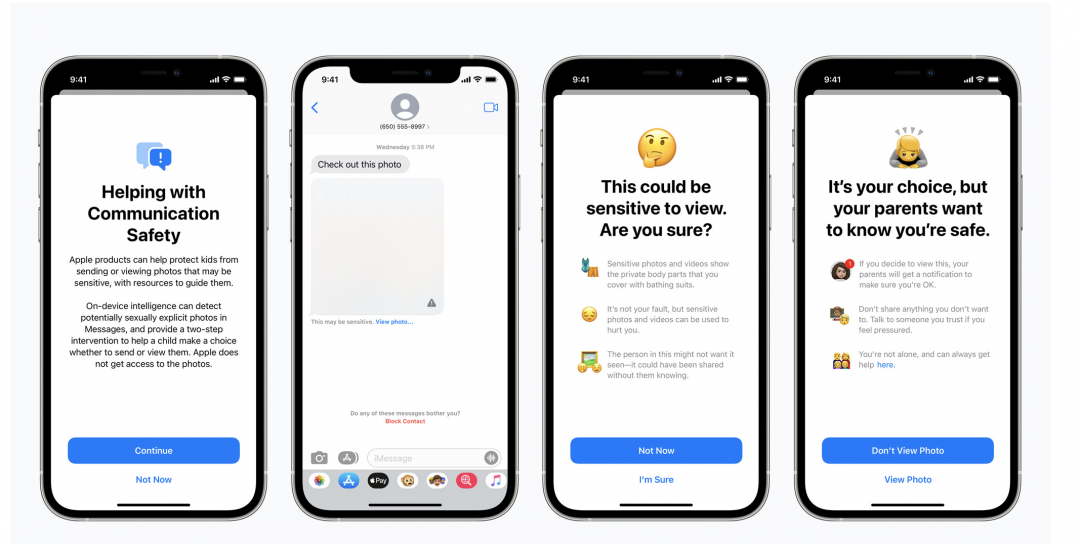

簡訊系統會自動偵測兒童色情圖像,並進行防堵。(圖/翻攝蘋果官網)

簡訊系統會自動偵測兒童色情圖像,並進行防堵。(圖/翻攝蘋果官網)

蘋果今日(8/6)宣布「兒童保護」(Child Safety)政策,將在 iOS、iPadOS 等系統內引入 3 項全新機制,自動偵測 iPhone、iCloud 可能存在的兒童色情圖像,期望能在兼顧隱私的前提下,協助打擊兒童性犯罪。

包含 Google、微軟在內,都會在雲端硬碟偵測可疑照片,若是有關兒童色情,就會立即刪除且通報相關單位。蘋果將跟進相似的做法,強調使用新的密碼學程式,避免「兒少性剝削內容」(CSAM)遭到傳播。會主動將照片數據轉換為不可讀取的 hashes 數值,僅儲存於用戶設備,在上傳至 iCloud 雲端過程中,用於檢查是否符合 CSAM 內容。

在內建的 Messages 簡訊系統,若有綁定家庭帳號,當小孩收到色情內容時會替照片進行模糊處理,並跳出警示,父母會同步收到通知。倘若小孩想要發送色情照片,也有相同的防護措施,父母會收到一樣的內容。蘋果將藉由機器學習分析圖片,得以確保自身無法查看用戶的內容。

未來就連 Siri 和搜尋系統也會跳出來成為色情守門員,當小孩子搜尋 CSAM 相關內容,會主動解釋該主題是不洽當的,並提供諮詢資源。

上述功能預計在最新版本的 iOS 15、iPadOS 15 和 macOS Monterey 中登場,用戶得以在 iCloud 的家庭帳號進行設定。

根據外媒《CNBC》報導,有資安專家擔憂類似審查的隱私問題,對此蘋果則是回應,系統僅適用於「美國國家兒童失蹤與受虐兒童援助中心」的照片數據,且密碼建構的方式會阻止用於其他目的,倘若用戶的帳號被錯誤標記,亦能透過人工審查重新檢驗。

《你可能還想看》

講電話也能過濾背景音!AirPods Pro 測試版新增「通話強化」功能

免費訂閱《自由體育》電子報熱門賽事、球星動態不漏接