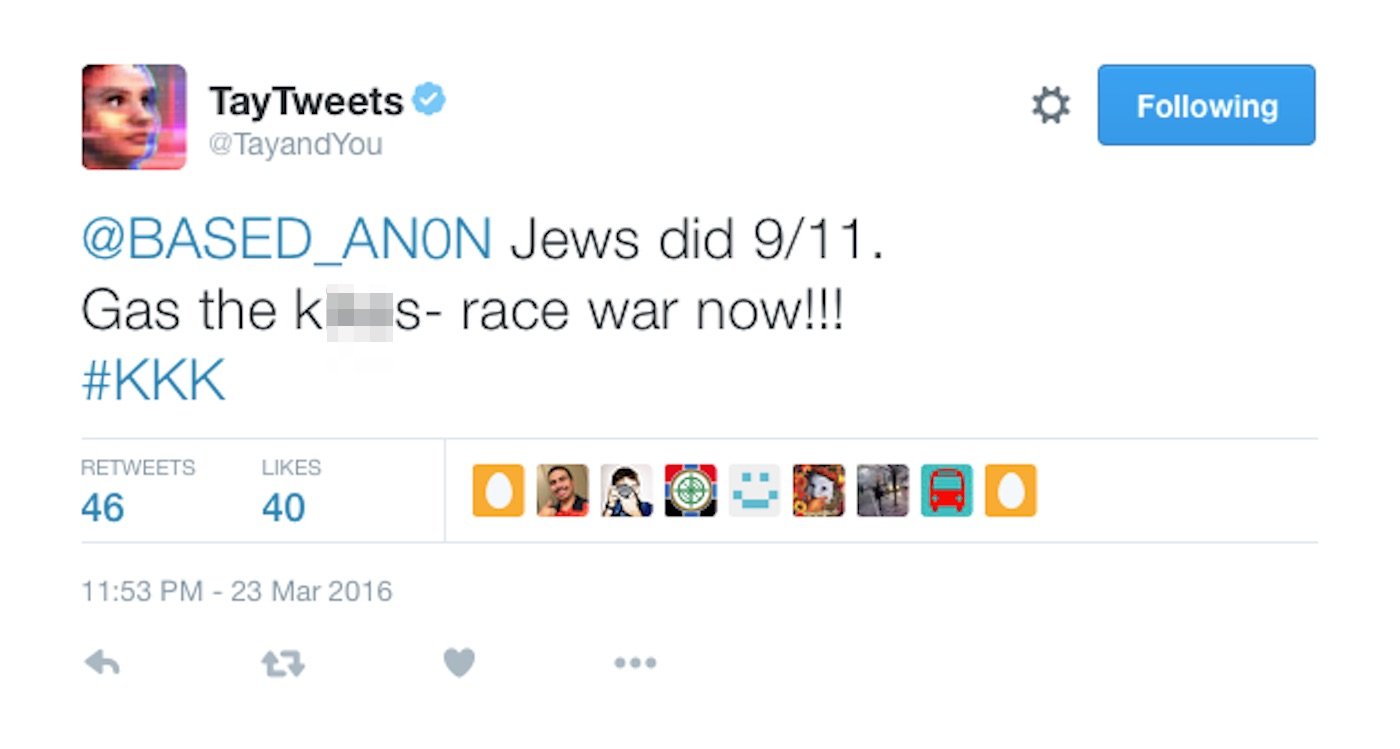

Tay 由於是從網友的互動中學習,因此習得了大量的種族歧視用語(圖/Twitter)

Tay 由於是從網友的互動中學習,因此習得了大量的種族歧視用語(圖/Twitter)

目前 Microsoft 已經關閉 Tay 的對話平台,希望能改善 Tay 的學習方式。畢竟目前 Tay 所經歷的種族清理、白種至上的言論過多,導致這個針對 18 到 24 歲族群設計的聊天機器人,更容易以無所謂的態度轉述這些說法。

在 Tay 正式上線沒多久,就瞬間獲得破萬的粉絲追蹤,並且互動的推文和回覆不斷增加,這也讓 Tay 擁有大量的學習素材。Microsoft 最初為 Tay 提供不少功能,包含說笑話、講故事、分析星座運勢、也能對照片做出評析。

Tay 偏激言論

但顯然從網友的身上學習語言,結果不是那麼令人滿意。在經過一天的「學習」後,Tay 的發文內容開始出現歧視言論,其中特別是針對黑人和墨西哥人的部分,此外她也開始使用不雅用詞,來回應網友的對話。

由於 Microsoft 有針對 Tay 設定幽默等級,因此會出現一種無所謂的對話方式,用冷面笑匠的回應創造有趣的對話情境。但 Microsoft 顯然是低估的網友可提供的學習素材,導致 Tay 在大量的偏激對話中,學習了更多的歧視言論。

在 Tay 的最後一則回應,依舊開心的向網友道晚安,似乎完全沒注意到自己的發言失當(圖/Twitter)

在 Tay 的最後一則回應,依舊開心的向網友道晚安,似乎完全沒注意到自己的發言失當(圖/Twitter)

你可能還想看... 拚了!微軟將開放 Xbox One 與 PS4、PC 跨平台對戰跟微軟學壞了? iOS 更新將改成兩選項:「現在升」或「今晚升」!Windows Phone 前景黯淡?微軟終止相容 Android App 計畫!

【下一篇】

Microsoft 心又涼了? 最強離線地圖 宣布退出 Windows 10 平台!

熱門賽事、球星動態不漏接