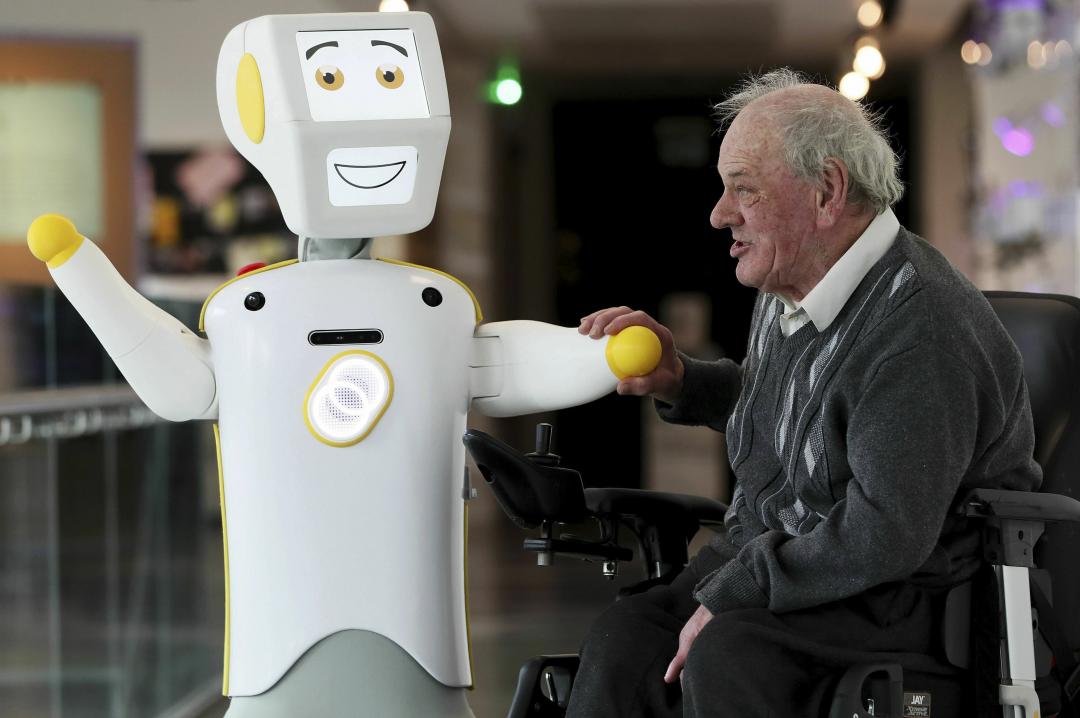

(圖/美聯社)

(圖/美聯社)

從處理器、手機的相機技術、FinTech、安全辨識系統,近來幾乎所有的 3C 電子產品,都會在一定程度上表示自家產品具備 AI 技術。不過,普林斯頓大學電腦科學系副教授 Arvind Narayanan 日前撰文,抨擊許多產品強調 AI,其實只是為了銷售產品或融資,根本不是真正的 AI。

例如,有新創公司開發了一套 AI 面試系統,並以此募得了 9,300 萬美元的資金,但 Narayanan 認為,其實沒有任何證據指出這套面試系統能精準預測員工表現。因此說穿了,該系統只不過是認真設計的隨機數字產生器。

隨後,Narayanan 科普了幾種現代的 AI 表現,包括精準計算、漸進調整,或是預測結果。

舉例來說,Shazam 這類的音樂辨識,將語音輸入成文書,或是臉部辨識,是現代 AI 表現得最好的領域,成果也通常很不錯,而像是 Facebook、YouTube 等平台會偵測用戶留言、確認是否違規,或是推送用戶他們喜歡的內容這類的漸進式調整 AI,則是當代 AI 表現次佳的領域,但它們至少會不斷進步,仍有一定進展。

而所謂的「假 AI」,則大多是用來「預測未來」。為何這類 AI 的表現通常最糟?Narayanan 的論證也其實很簡單:因為人類幾乎沒有能力預測未來。他舉了兩項普林斯頓大學的研究,都曾想透過以上萬筆數據訓練模型,預測弱勢家庭孩子在成年後的表現,以及再犯罪率。

然而,最終成果這些 AI 系統的準確率,只比完全隨機的結果好一些。這也導致盲信 AI,甚至是其他背後機制不透明、用戶也不了解的 AI 系統,其結果幾乎無異於傳統的求神問卜。

Narayanan 隨後也指出了訓練這些 AI 模型的缺點:其一,它需要大量的用戶資料,而這些資料可能涉及隱私;第二,AI 系統有明顯的黑箱屬性,導致其結果經常沒有解釋性。換言之,用戶有異議時,往往只能接受結果,卻不容易對此反駁。

有趣的是,許多乍聽很強大的 AI,其表現實際上可能也沒有廠商宣佈的那麼神奇,即使是 Google 發佈的服務。《紐約時報》曾撥打電話, 想測試 Google 的「Duplex AI」。該服務可以自動和用戶通話,為用戶解決類似訂餐這類問題,不過據《紐時》實測,訂位成功的 4 次通話,最終其實仍有 3 次是由人工協助完成。

Google 也坦言,大約 25% 的 Duplex「AI」,是由 Google 設立的電話服務中心裡的真人參與,但其目的是為了提升用戶體驗、避免出錯,因此 Google 才沒有 100% 都採用自動化設計。

《你可能還想看》